Robots.txt adalah Unsur Penting dalam SEO

Robots Txt Adalah – Boldee! Ketika Kamu melakukan optimisasi pada sebuah situs web, salah satu faktor yang memerlukan perhatian adalah file robots.txt. Robots txt adalah sebuah file teks yang ditempatkan di akar situs web Kamu yang memberi petunjuk kepada Bot mesin pencari dan Bot lainnya tentang bagian situs web mana yang boleh atau tidak boleh diindeks.

Rayapan beberapa Bot pada situs web menjadi penting, terutama bot yang terkait dengan mesin pencari. Tujuan dari file robots.txt adalah mempermudah situs web dalam ditemukan oleh mesin pencari seperti Google atau Bing.

Oleh karena itu, peran file robots.txt sangatlah signifikan, karena memutuskan apakah pengindeksan oleh mesin pencari diizinkan atau ditolak. Dengan adanya file robots.txt yang tepat, Kamu dapat mengontrol bagaimana Bot mesin pencari berinteraksi dengan konten situs web Kamu.

Dalam panduan ini, kami akan memberikan informasi mengenai apa yang dimaksud dengan file robots.txt dan perannya pada sebuah situs web. Dengan pemahaman yang tepat tentang cara menggunakan dan mengatur file robots.txt, Kamu dapat mengoptimalkan visibilitas dan kinerja situs web Kamu di mesin pencari. Berikut ini adalah informasi lebih lanjut.

Pengertian Robots.txt Adalah

Sebelum kita melanjutkan diskusi tentang file robots.txt, mari kita memiliki pemahaman awal mengenai tujuan sebenarnya dari file ini. Robots.txt adalah suatu alat yang berisi instruksi yang ditujukan kepada berbagai bot yang melakukan proses crawling di suatu situs web.

Melalui file ini, setiap bot diberikan panduan khusus, termasuk apakah mereka diizinkan untuk mengakses seluruh halaman situs web, hanya beberapa halaman tertentu, atau bahkan apakah mereka dilarang mengakses halaman-halaman tertentu di situs web Kamu. Biasanya, file diletakkan pada direktori utama suatu situs web dan bisa diakses melalui URL situs web seperti contohnya: namadomainanda/robots.txt.

Tetapi, penting untuk diingat bahwa file robots.txt bukanlah alat yang efektif untuk menjaga keamanan informasi situs web. File ini hanya mengatur akses bot-bat dari mesin pencari, sementara pengguna dan pengunjung situs web masih tetap bisa mengakses halaman-halaman yang tidak diindeks jika mereka mengetahui URL-nya. Oleh karena itu, meskipun file robots.txt memiliki peran penting dalam mengatur aktivitas Bot, tetap lebih baik menjaga keamanan informasi situs dengan cara lain.

Fungsi Robots.txt

Sesuai dengan penjelasan yang telah diberikan, fungsi utama dari robots.txt adalah mengatur instruksi bagi setiap Bot yang akan melakukan proses crawling di sebuah situs web. Selain itu, terdapat beberapa fungsi lain dari file robots.txt:

- Mengurangi akses Bot crawling pada situs web, sehingga memastikan beban server tetap terjaga.

- Mencegah Bot dari mesin pencari untuk melakukan crawling terhadap konten duplikat.

- Menentukan halaman-halaman mana yang diperbolehkan untuk di-crawl.

Cara Membuat Robots.txt

Sebelum Kamu membuat file Robots.txt, penting untuk memiliki pemahaman tentang beberapa istilah yang sering digunakan dalam pembuatan file tersebut, di antaranya:

- User Agent: User agent digunakan untuk mengidentifikasi Bot yang diizinkan untuk melakukan crawling pada website Kamu. Sebagai contoh, user agent Googlebot

- Allow: Instruksi “allow” berfungsi untuk memberi izin kepada user agent untuk melakukan crawling pada website Kamu.

- Disallow: Instruksi “disallow” digunakan untuk melarang user agent melakukan crawling pada bagian tertentu dari website Kamu.

- Sitemap: Instruksi “sitemap” digunakan untuk memberikan informasi lokasi sitemap pada website Kamu. Tujuannya adalah agar user agent dapat melakukan crawling berdasarkan informasi yang ada di sitemap.

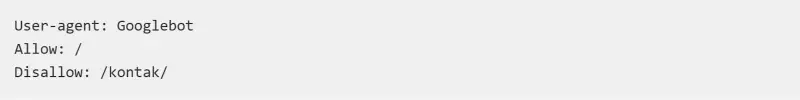

Setelah memahami istilah-istilah tersebut, Kamu dapat membuat file robots.txt. Langkah pertama adalah membuat file tersebut dan mengeditnya menggunakan text editor seperti Notepad. Selanjutnya, Kamu dapat mengisi instruksi-instruksi yang sesuai dengan kebutuhan dalam file robots.txt tersebut. Berikut adalah contoh beberapa instruksi yang dapat Kamu gunakan sebelum membuat file robots.txt adalah di antaranya :

Berdasarkan petunjuk di atas, hasilnya akan mengizinkan Bot dari mesin pencari Google, yaitu Googlebot, untuk melakukan crawling pada seluruh data di dalam website, kecuali data yang terdapat dalam folder kontak.

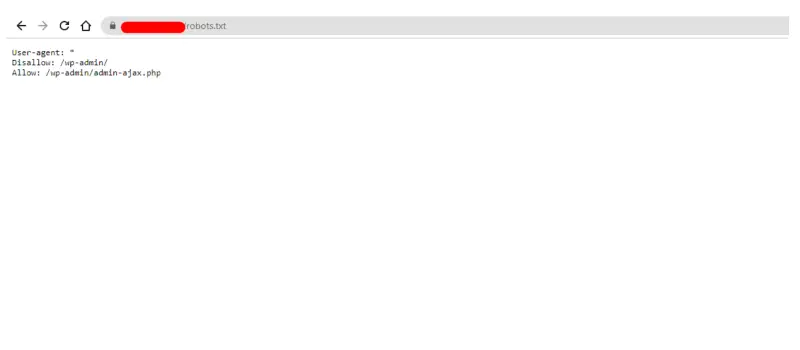

Setelah berhasil membuat file robots.txt, langkah selanjutnya adalah mengunggah file tersebut ke dalam folder situs web Kamu. Kamu dapat melakukan pengunggahan ini menggunakan protokol FTP. Untuk langkah-langkahnya, Kamu dapat mengklik di sini.

Setelah file berhasil diunggah, Kamu dapat memeriksanya dengan mengakses URL namadomain/robots.txt. Jika tampilan yang muncul sesuai dengan instruksi yang telah Kamu tuliskan, maka langkah pengunggahan telah berhasil dilakukan.

Cara Cek Robots.txt dari GSC

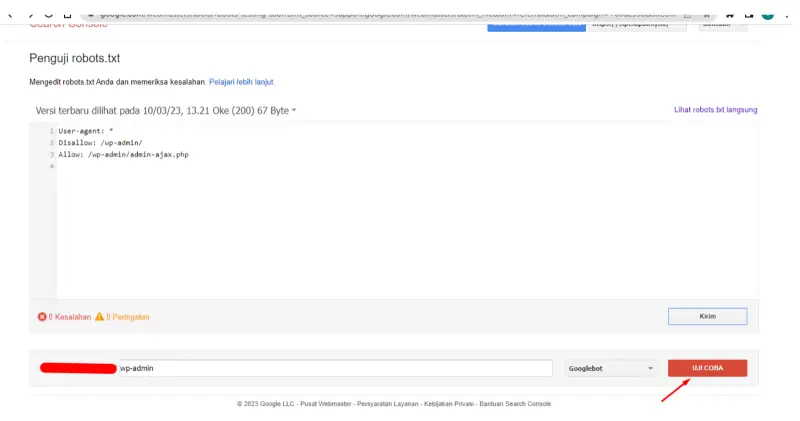

Setelah berhasil membuat dan mengunggah file robots.txt, langkah selanjutnya adalah menguji skrip menggunakan alat Google Search Console (GSC). Pertama-tama, silakan masuk ke akun GSC yang digunakan. Jika domain belum ditambahkan, ikuti panduan di tautan ini untuk menambahkannya terlebih dahulu.

Setelah itu, akses URL uji coba robots.txt di sini. Apabila file robots.txt sudah ada, akan muncul instruksi sesuai dengan isi file robots.txt pada situs web Kamu. Ini adalah cara untuk memastikan bahwa robots.txt adalah diatur dengan benar. Untuk melakukan pengujian, cukup klik tombol uji coba yang tersedia di bagian bawah halaman.

Jika hasil yang ditampilkan sesuai dengan petunjuk yang telah Kamu tentukan, maka dapat dianggap bahwa file robots.txt sudah berjalan sesuai dengan instruksinya.

Demikian penjelasan mengenai apa itu robots.txt. Diharapkan penjelasan mengenai robot.txt dapat memberikan tambahan informasi dan mendukung Kamu dalam mengelola situs web Kamu. Selain itu, tujuan dari robot.txt adalah untuk mengatur instruksi kepada bot-bat yang melakukan proses crawling di situs web Kamu.

Baca juga: Apa itu Web Crawler? Arti, Cara Kerja, Jenis, dan Contohnya

OHBold Creative Agency

Membantu Brand Memenangkan Pasar.

Info Selengkapnya